Definición y conceptos básicos de la inteligencia artificial

La inteligencia artificial es una rama de la informática que busca desarrollar sistemas capaces de realizar tareas que, al ser hechas por personas, requerirían inteligencia. Estas tareas incluyen el aprendizaje, el razonamiento, la resolución de problemas y la percepción. Existen dos tipos principales de inteligencia artificial: la IA débil, diseñada para tareas específicas como asistentes de voz, y la IA fuerte, que aspira a replicar la inteligencia humana general, aunque todavía está en desarrollo. Utilizando algoritmos avanzados y grandes cantidades de datos, la IA permite que las máquinas mejoren su desempeño de manera autónoma, aprendiendo a base de patrones y experiencias.

Historia de la inteligencia artificial

La historia de la inteligencia artificial comenzó formalmente en 1956, cuándo el término fue inventado por John McCarthy durante la conferencia de Dartmouth, aunque sus raíces se remontan a teorías filosóficas sobre la mente y la lógica. Los primeros avances se enfocan en programas que resolvían problemas matemáticos y varios juegos simples. Durante las décadas de los años, la IA pasó por varios “inviernos”, periodos de estancamiento debido a que no cumplía las expectativas y faltaba financiación. Sin embargo, con el incremento de poder computacional y el auge del aprendizaje automático en los años 2000, la IA resurgió, logrando importantes avances en el reconocimiento de voz, procesamiento de imágenes y automatización.

Técnicas fundamentales en IA: MAchine Learning y Deep Learning

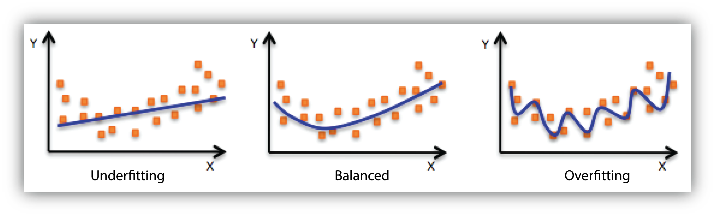

El machine learning y el deep learning son técnicas fundamentales en el desarrollo de la inteligencia artificial. El machine learning permite que las máquinas aprendan de datos sin programación específica, mejorando su desempeño en tareas como predicción y clasificación. Dentro de esta áreas, el deep learning utiliza redes neuronales artificiales profundas, lo que permite a los sistemas analizar patrones complejos en grandes volúmenes de datos, como el reconocimiento de voz e imágenes. Estas técnicas han impulsado innovaciones en diversos sectores, desde la medicina hasta la industria automotriz, y son clave para desarrollar aplicaciones más precisas y autónomas.

Redes neuronales y algoritmos de IA

Las redes neuronales y los algoritmos de inteligencia artificial son esenciales para el aprendizaje y procesamiento de información en sistemas avanzados de IA. Inspiradas en el cerebro humano, las redes neuronales permiten a las máquinas identificar patrones complejos en datos, empleando capas de neuronas artificiales conectadas entre sí. Existen distintos tipos de redes, como las convolucionales (CNN) para análisis de imágenes y las recurrentes (RNN) para procesamiento de secuencias, como el lenguaje. Junto a otros algoritmos, como árboles de decisión de y métodos de clustering, estos modelos permiten que la IA realice tareas complejas de predicción y clasificación en múltiples campos.

Procesamiento de lenguaje natural (NLP)

El procesamiento de lenguaje natural (NLP) es una rama de la inteligencia artificial que permite a las máquinas entender, interpretar y generar lenguaje humano de forma coherente. Utilizado en aplicaciones como asistentes virtuales, traductores automáticos y chatbots, el PNL facilita interacciones más naturales entre personas y sistemas informáticos. Modos avanzados, como GPT y BERT, han mejorado significativamente la comprensión y generación de texto al aprender de grandes volúmenes de datos textuales. Gracias a estas técnicas, el NLP puede analizar el contexto de identificar puede analizar el contexto, identificar emociones y responder preguntas, abriendo oportunidades en áreas como atención al cliente, educación y generación automática de contenidos.

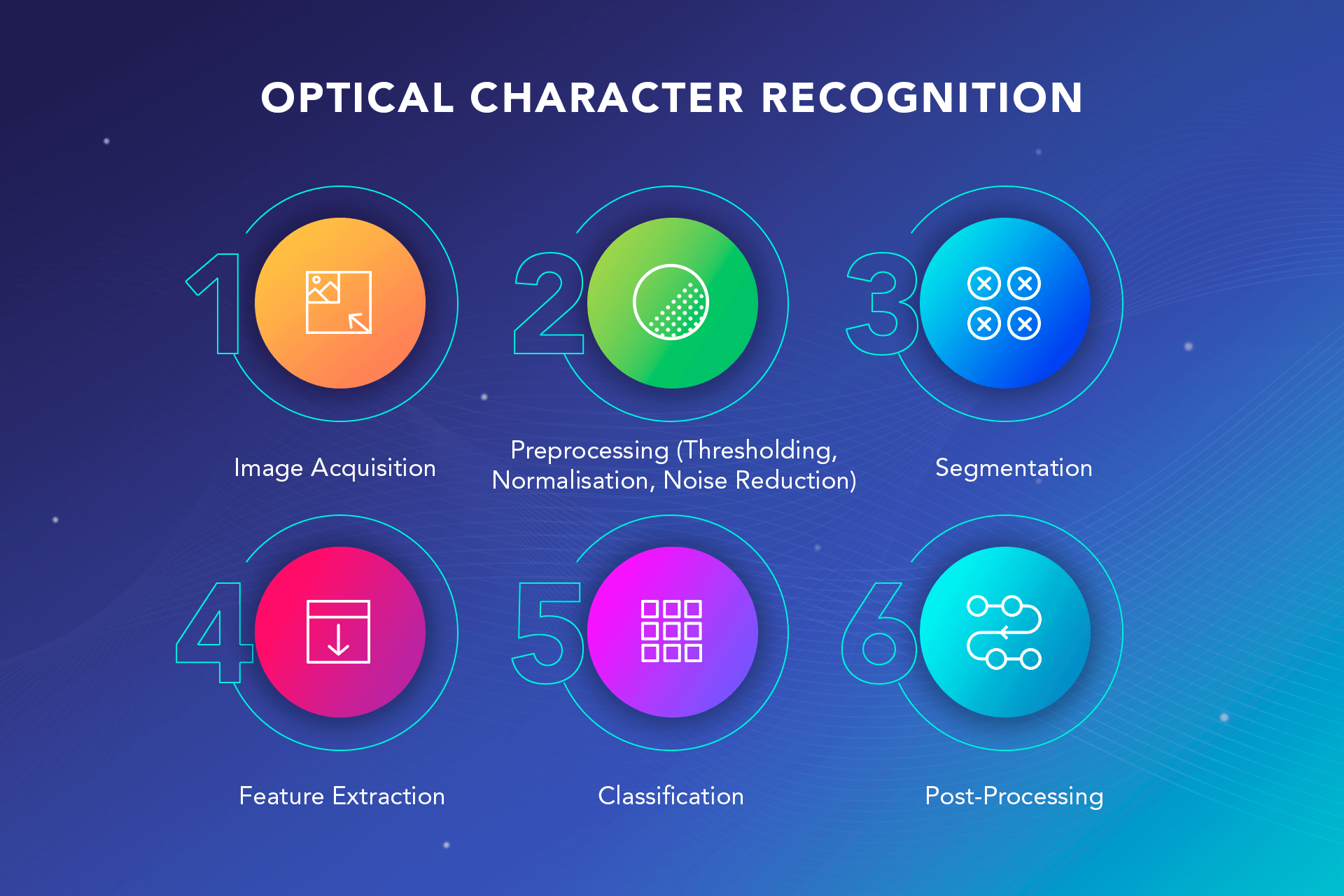

Visión por computadora.

La visión por computadora es un campo de la inteligencia artificial que permite a las máquinas interpretar y analizar imágenes o vídeos, simulando la capacidad de “ver” de las personas. Utilizando técnicas de redes neuronales convolucionales (CNN), la visión por computadora identifica patrones visuales y objetos, siendo clave en aplicaciones como el reconocimiento facial, la conducción autónoma y el diagnóstico médico. Esta tecnología permite analizar grandes volúmenes de datos visuales con alta precisión y rapidez, facilitando tareas que antes requerían la supervisión de las personas. Su avance está transformando industrias al hacer posible la automatización en áreas como seguridad, manufactura y salud.

Ética y responsabilidad en la IA

La ética y responsabilidad en la inteligencia artificial son fundamentales para garantizar que esta tecnología beneficie a la sociedad de manera justa y segura. A medida que los sistemas de IA se integran en mareas como la salud, la justicia y la seguridad. A medida que los sistemas de IA se integran en áreas como la salud, la justicia y la seguridad, surgen preocupaciones sobre la privacidad, el sesgo algorítmico y el impacto en el empleo. Es crucial desarrollar y aplicar regulaciones que aseguren que los algoritmos sean transparentes. explicables y no discriminen a ciertos grupos. Además, la IA debe ser utilizada de manera que respete los derechos humanos y promueva la equidad. La creación de marcos éticos robustos es esencial para mitigar los riesgos y maximizar los beneficios de la IA.

Futuro de la IA

El futuro de la IA promete avances transformadores en múltiples áreas, desde la medicina hasta la educación y el transporte. Se espera que la IA evolucione hacia sistemas más inteligentes y autónomos, capaces de realizar tareas complejas de manera más eficiente y creativa, incluso en entornos cambiantes. Sin embargo, el desarrollo de una inteligencia artificial general (AGI) que imite la cognición de las personas plantea tanto oportunidades como desafíos éticos y sociales. La colaboración entre personas e inteligencia artificial será clave para mejorar la productividad, la toma de decisiones y la innovación. A medida que la tecnología progresa, será esencial un enfoque equilibrado para asegurar su desarrollo responsable y su integración armoniosa en la sociedad.