Definición del método Kernel

El método de núcleo (Kernel Method) es una técnica matemática utilizada en el aprendizaje automático para transformar datos no lineales en un espacio de características de mayor dimensión, donde pueden ser tratados de manera lineal. En lugar de realizar limpiamente esta transformación, se utiliza una función llamada kernel, que calcula el producto interno de los datos en el nuevo espacio sin necesidad de conocer la transformación exacta. Esta técnica es fundamental para resolver problemas complejos en clasificación, regresión y otros modelos, permitiendo trabajar con datos de alta dimensión de manera eficiente. El uso del truco del kernel ahorra tiempo y recursos computacionales. Es ampliamente aplicado en algoritmos como las máquinas de soporte vectorial (SVM).

Fundamentos matemáticos

Los fundamentos matemáticos del método del núcleo se basan en el concepto de transformaciones no lineales de datos en un espacio de características de mayor dimensión. La clave del método es utilizar una función kernel , que calcula el producto interno entre dos vectores en este espacio transformado, sin necesidad de realizar la transformación explícita. Esto se conoce como el truco del kernel , ya que permite evitar cálculos costosos al trabajar directamente en el espacio de características superiores. Matemáticamente, el núcleo K (incógnita,y) K (x, y) K ( x ,y ) se define como ⟨ϕ(incógnita), ϕ(y)⟩\langle \phi(x), \phi(y) \rangle⟨ ϕ ( x ) ,ϕ ( y )⟩, donde ϕ (incógnita)\phi(x)ϕ ( x ) es la transformación de los datos. Este enfoque hace posible tratar problemas no lineales de manera eficiente.

El truco del Kernel

El truco de kernel es una técnica que permite calcular el producto interno de dos datos en un espacio de características de alta dimensión sin tener de núcleo (o kernel), se determina la transformación a ese espacio. Mediante el uso de una función de núcleo ( o kernel), se determina directamente el producto interno, evitando el alto costo computacional que implicaría calcular la transformación completa. Esto permite que los modelos de aprendizaje automático, como las máquinas de soporte vectorial, puedan manejar datos no lineales de manera eficiente. El truco del kernel es esencial para aplicar el método del núcleo en problemas complejos sin aumentar la carga computacional.

Tipos de núcleos comunes

Existen varios tipos de núcleos (kernels) comunes que se eligen según el tipo de datos y problema a resolver en aprendizaje automático. El kernel lineal es el más simple, útil y más complejo al elevar el producto interno de los datos a una potencia determinada. El kernel polinómico permite relaciones más complejas al elevar el producto interno de los datos a una potencia determinada. El kernel gaussiano o RBF es uno de los más usados en problemas no lineales, ya que calcula la similitud exponencial entre puntos, ideal para datos sin una estructura lineal clara. Otros núcleos, como el sigmoidal, se inspiran en las funciones de activación de redes neuronales, ampliando las opciones para distintos escenarios.

Aplicaciones en máquinas de soporte vectorial (SVM)

En máquinas de soporte vectorial (SVM), el método del núcleo es fundamental para clasificar datos que no son linealmente separables en su espacio original. Utilizando un kernel adecuado, las SVM transforman los datos a un espacio de mayor dimensión donde pueden ser separados por un hiperplano lineal, facilitando la clasificación de datos complejos. Este enfoque permite que SVM maneje tareas de clasificación y regresión, logrando una separación óptima de clases en datos no lineales. Las SVM con kernel son ampliamente utilizadas en reconocimiento de imágenes, detección de texto y bioinformática debido a su precisión y capacidad para adaptarse a datos complejos.

Ventajas del método del núcleo

El método del núcleo ofrece varias al trabajar con datos no lineales en aprendizaje automático. Permite transformar problemas complejos en espacios de mayor dimensión donde las relaciones entre datos se vuelvan lineales, facilitando su análisis y resolución. Además, el truco del kernel evita la necesidad de calcular explícitamente estas transformaciones, ahorrando recursos computacionales. Esta flexibilidad permite adaptar el modelo a distintos tipos de datos mediante la selección de diferentes funciones de núcleo. Gracias a estas capacidades, el método del núcleo es clave en modelo como SVM y en tareas de clasificación y regresión complejas.

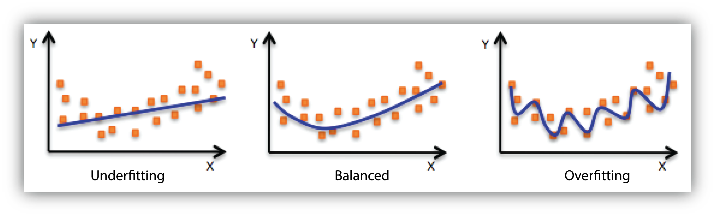

Desventajas del método de núcleo

El método del núcleo también presenta algunas desventajas, especialmente en la elección del kernel adecuado, que puede ser un proceso complejo y crítico para obtener buenos resultados. Algunos kernels requieren un ajuste preciso de parámetros, como el parámetro \(\gamma\) en el kernel Gaussiano, cuya mala elección puede llevar a un sobreajuste o a un rendimiento deficiente. Además, aunque el truco del kernel reduce la carga de cálculo, trabajar con grandes conjuntos de datos aún puede resultar costoso en términos computacionales. Finalmente, la interpretación de los modelos basados en kernels es menos intuitiva, lo que puede complicar su uso en aplicaciones que requieren explicabilidad.

Futuro del método de núcleo

El futuro del método del núcleo en aprendizaje automático parece prometedor, especialmente al combinarse con enfoques avanzados como las redes neuronales profundas y el aprendizaje no supervisado. Con el desarrollo de kernels más específicos y adaptativos, el método puede ampliarse a aplicaciones en datos aún más complejos y en áreas emergentes como la visión por computadora y el procesamiento de lenguaje natural. Además, los avances en computación cuántica podrían hacer posibles cálculos de kernel a gran escala, permitiendo trabajar con conjuntos de datos masivos en menos tiempo. A medida que los algoritmos se vuelven más eficientes, el método del núcleo podría integrarse aún más en sistemas de IA que requieren modelos robustos y precisos en entornos no lineales.